近日,信号处理理论和实践领域国际刊物《Signal Processing》(JCR Q2,IF:4.729)报道了人工智能学院信息融合团队在无线传感器网络无距离节点定位方向的研究进展,相关成果以“Robust DCF object tracking with adaptive spatial and temporal regularization based on target appearance variation”为题在线发表。

在当今物联网和“互联网+”时代,基于计算机视觉对象跟踪技术的场景监控、自动驾驶、无人机导航、人机交互等服务蓬勃发展。 因此,视频对象跟踪方法引起了学术界和工业界的广泛关注和深入研究。 视频目标跟踪的任务是根据目标在第一帧中的初始位置和尺度信息预测视频序列中单个目标的状态。 然而,复杂环境引起的变形、遮挡、光照变化和背景杂乱等因素使视觉目标跟踪具有挑战性。 因此,提高跟踪器对干扰的鲁棒性和对目标变化的适应性具有重要意义。

具有固定系数的空间和时间正则化约束通常用于当前跟踪方法的目标函数中。正则化约束可以减少边界效应的影响,增强跟踪模型的鲁棒性。然而,它们极大地限制了跟踪器对目标外观变化的适应性。在目标外观变化较大的情况下,跟踪器容易丢失目标。为了减轻边界效应并约束跟踪模型的更新,当前基于判别相关滤波器(DCF)的目标跟踪方法通常在滤波器训练目标函数中引入空间和时间正则化约束。然而,这些具有固定系数的正则化约束极大地限制了跟踪器对目标外观变化的适应性。

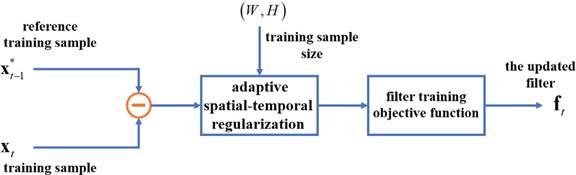

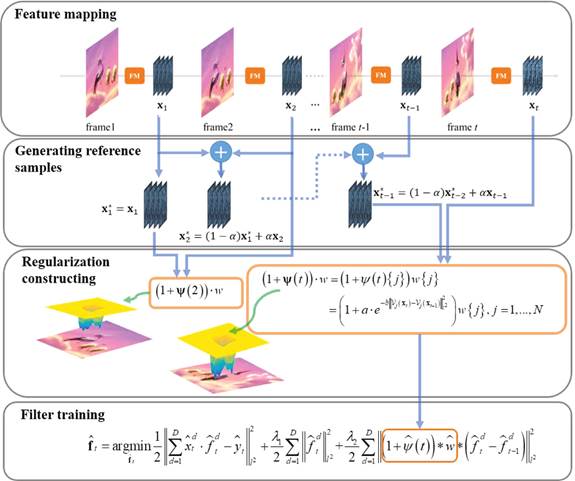

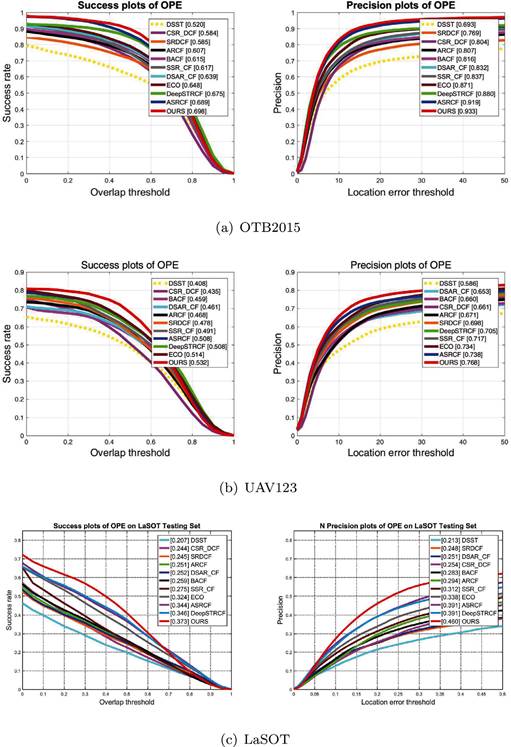

为了尽可能保持跟踪鲁棒性并提高跟踪器的适应性,本文将基于目标外观变化的自适应时空正则化约束嵌入到滤波器训练目标函数中。该方法的主要创新点如下:本文构建了一个基于目标外观变化的自适应时空正则化模型。与传统跟踪器中固定系数的正则化不同,该方法可以根据目标外观的实时变化自适应调整正则化系数,从而显着提高跟踪器的适应性和鲁棒性。本文在提出的自适应时空正则化下提出了一种新颖的滤波器训练目标函数。并提出了一种基于交替方向法(ADMM)的迭代目标函数求解算法,在保证跟踪速度的同时提高跟踪精度。本文对 OTB2015、UAV123 和 LaSOT 数据集进行了广泛的实验,以验证我们的方法优于采用空间正则化或时间正则化技术的最先进竞争对手,如 ASRCF、ARCF、STRCF 等上。

河南大学人工智能学院为该论文的第一单位,信息融合团队周林副教授为第一作者,河南大学人工智能学院教授金勇为通讯作者。该研究工作为河南大学人工智能学院与计算机学院共同开展的联合研究成果,受到国家自然科学基金面上项目、河南省科技厅科技攻关项目和河南省教育厅科学技术研究重点项目等课题的资助。

论文链接:https://www.sciencedirect.com/science/article/abs/pii/S016516842200010X

图1. 使用自适应时空正则化模型进行滤波器训练

图2. 使用自适应时空正则化模型进行滤波器训练

图3. OTB2015(a)、UAV123(b)和LaSOT(c)上的成功图和精度图

图4. 实测结果